推荐阅读

【论道PPT】国研能汇江忻玺:智驭未来视界——人工智能开创视听新纪元

2024年10月31-11月1日,由流媒体网主办,广西广电新媒体有限公司 、中国电信广西区分公司、中国联通广西区分公司共同协办的「南宁论道暨第28届智能视听与科技创新产业论坛」在南宁隆重举行。

本届论道以“聚视而行 和合致远”为主题,共筑视听新质,同启智屏未来。

在10月31日举行的“新质引领——IPTV价值创新论坛”上,国研能汇(北京)技术有限公司总经理江忻玺做了主题为《智驭未来视界——人工智能开创视听新纪元》的演讲。

以下为演讲全文:

各位嘉宾、朋友,大家下午好!

今天给大家带来的分享主题是《智驭未来视界--人工智能开创视听新纪元》。我将从四个方面进行介绍:全球视听——数字浪潮下的突破与挑战;智能交互——国研能汇产品矩阵;从算法到艺术——国研能汇技术支撑;未来已来——AI引领视听行业数字化变革。

全球视听:数字浪潮下的突破与挑战

从全球视听行业的现状与趋势中,我们可以看到,随着沉浸式体验需求的增长,以及AI个性化推荐的引领,全球视听市场正在快速扩张。首先,虚拟现实和增强现实等技术正逐步成为提升视听体验的关键,它们能够为观众带来更加逼真的感受。

与此同时,流媒体平台的崛起同样推动了视听市场的发展。我们可以看到,像Netflix和YouTube这样的国际平台,以及国内的爱优腾、抖音、快手等平台,已经成为视听内容消费的重要媒介。

硬件方面的升级,例如高清显示器和智能音响等设备,也为视听体验的提升提供了技术支持。

最为重要的是,人工智能的广泛应用改变了内容创作和分发的方式。短视频平台如抖音、快手的算法能够通过AI提升用户的参与感,并且帮助创作者产生更多创新的内容。

最后,从市场规模的角度来看,全球视听市场在2023年达到了3070亿美元,并且预计到2028年将增长至4020亿美元。

可以参考一些国外视听行业的新技术应用案例。

Netflix和TikTok的个性化推荐算法通过机器学习,根据用户偏好提供精准内容推荐,从而极大提升了用户的观看体验。据统计,Netflix在2022年通过个性化推荐将用户观看时长提高了约80%,充分彰显了推荐算法在视听领域的潜力。此外,Disney+的AR技术为用户带来了互动式观影体验。这种技术应用不仅丰富了平台功能,还为用户提供了更加身临其境的娱乐方式。可以说,这种沉浸式体验是未来娱乐平台创新的标杆。而Sony的虚拟歌手“初音未来”更是运用AI和3D全息投影技术,为全球粉丝呈现了虚拟偶像体验,标志着AI在音乐领域的突破,引领虚拟艺人和AI娱乐的新潮流。

当前,以抖音、快手为代表的短视频行业用户规模已经突破10亿,AI推荐技术推动了其快速增长,短视频也已经成为视听产业必不可缺的媒介。

目前,中办、国办、发改委、文旅部、科技部分别出台了一系列政策,以推动国内视听行业的数字化转型和AI赋能发展。这些政策为AI在视听行业的普及化应用提供了支持,使得AI技术能够更加深入地影响和提升国内视听行业的整体水平。

首先,从工具赋能的角度看,AI技术在视听内容的制作上变得越来越普及。过去,视听创作更多集中在高端影视制作领域,而如今AI技术的应用逐渐延伸到了短视频平台。例如抖音和快手,通过智能剪辑、滤镜推荐等功能,AI大大提升了普通用户的创作水平,让更多人能够制作出高质量的内容。这意味着,不管是专业创作者还是普通用户,都能借助AI技术发挥创意,实现更出色的作品。

其次,表现形式的多样化也得到了进一步发展。AI生成的内容不仅限于文字或传统视频,甚至可以融合虚拟现实(VR)和增强现实(AR)技术,为用户带来更加沉浸式的体验。特别是在文旅、直播等在线消费领域,AI已经能够提供虚拟导览、互动式服务,进一步提升了用户的体验感和参与感。这些形式的多样化,显示了AI技术在各个领域中的广泛应用。

在当前全球视听产业格局中,欧美在影视创作和虚拟现实等领域依然占据优势,而中国则凭借庞大的用户市场和丰富的数据资源,通过AI算法实现快速追赶,抖音的个性化推荐便是一个成功的代表性案例。

可以说,AI技术赋能的普及化,正为国内视听行业注入更多的创意与活力,推动行业向更丰富、更多样化的方向发展。

智能交互:国研能汇产品矩阵

我们有一些自研实用工具赋能IPTV场景的例子。

AI+自动剪辑

让我们聚焦用户痛点,特别是AI+自动剪辑如何帮助用户快速获取剧集信息。追剧时,许多用户常忘记关键情节,难以迅速定位。针对这一痛点,平台通过自动识别剧情节点,为用户生成简短的回顾视频,帮助快速掌握情节走向,避免错过关键内容。此外,平台还提供3分钟混剪功能,概述核心剧情与冲突,让用户判断是否继续追剧。AI剪辑功能还可自动提取重要片段,聚焦关键情节,省去冗长内容。而针对时间有限的用户,平台提供矛盾点和转折点提取,帮助迅速掌握剧情核心。同时,非剧透剧情总结为用户提供剧情脉络,既不过度暴露情节,又便于讨论和理解。这些AI剪辑功能有效解决了追剧中的痛点,让用户更高效地享受影视乐趣。

AI+业务问答

在现代企业的管理中,信息检索效率直接影响到决策的速度和质量。根据《麦肯锡全球研究院》的报告,信息沟通不畅会严重影响企业的生产力。数据显示,生产力的下降幅度可能高达20%至30%,这对企业来说是一个非常严峻的问题。尤其是当信息无法及时或不准确传达时,决策错误可能会导致企业每年损失数百万美元。

为解决这一问题,国研能汇推出基于小程序或公众号的业务问答平台,将人事、财务、会议等业务模块整合在一个系统中,让员工无需等待即可快速获取所需信息。例如,当员工需要查询流程或政策时,系统会通过AI即时提供精准答案,大幅提升信息流通效率,减少人力资源浪费,避免沟通不畅导致的决策失误。未来,企业管理将愈加依赖这种智能平台,简化流程、实现部门间的信息共享,从而提升运营效率,支持更科学、精准的决策。

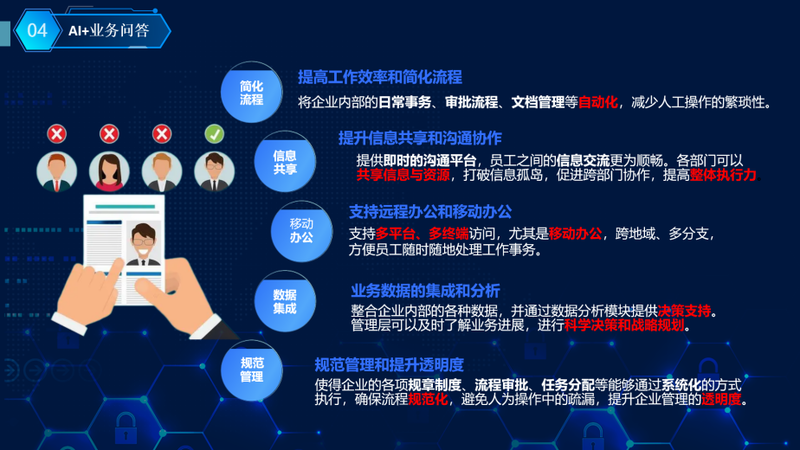

而AI+业务问答模型可以通过自动化处理日常事务、审批和文档管理,简化流程,减少人为错误,使员工专注于核心任务,提升工作效率。同时,AI系统促进部门间信息共享,打破信息孤岛,提升协作效率。并且AI问答系统支持远程和移动办公,确保员工随时随地高效处理事务。集成的数据分析功能让管理者实时掌握业务指标,提供决策支持,帮助预测风险和识别趋势,从而提升企业竞争力。这一系统还通过流程和任务的自动化执行提高管理透明度,带来效率革命,为企业管理带来科学性和规范性。

AI+文生图

AIGC应用工具方面,可以看AI生成图像领域的两大强力模型——DALL·E 3 和 SDXL,并对比它们在复杂提示词生成方面的表现。

比如这次的提示词是‘左有冰山,右有火山,冰火两重天’。这类提示词对模型生成的要求非常高,因为需要同时准确生成两个极具对比性的自然元素。

从展示结果来看,SDXL的表现明显不符合要求。尽管它生成了冰山,但并没有展现出火山,未能很好地理解和执行提示中的复杂场景要求。而DALL·E 3则稍有进步,它生成了冰山和火山,但火山的细节表现较为模糊,未能完美展现出理想中的火山效果。不过,整体上DALL·E 3在复杂场景生成的控制力和准确性上要优于SDXL。

最后看最右边的图片,这是我们自己的RPG模型生成的效果。可以看到,我们的模型不仅准确捕捉了冰山和火山的对比景象,而且在色彩、细节和整体画面自然度上做到了极致,甚至远超了其他两大主流生成模型。

通过这个对比,我们可以清楚地看到,不同生成模型在面对复杂场景时的能力差异。DALL·E 3和SDXL在某些方面具备优势,但当面对超长、超复杂的提示词时,显然我们的RPG模型在准确性和自然度上表现更为出色。

综上所述,我们自己的生成模型在应对复杂提示词、精准场景构建以及生成图片的自然度方面具有显著的优势,这也为未来的AI图像生成提供了更多可能性。

再分享一个AI生成图像的实际案例,并对比了不同模型在处理复杂提示词时的表现。

这次的提示词是‘沙发上坐着一个穿橙色裙子的绿发女孩,右边大窗户下面是一张凌乱的桌子,热带的水族箱在沙发的右上方’。这个提示词对生成图像的准确性要求很高,需要同时处理多个对象以及相对复杂的场景布局。

我们来看SDXL的表现。可以看到,SDXL生成了绿发女孩和水族箱,但它没有生成凌乱的桌子,而且水族箱的位置也有偏差,这说明它在处理多重元素时有一定的局限性。

接下来是DALL·E 3。它生成了绿发女孩、水族箱,并且基本达到了提示词中的要求。但同样,它没有生成桌子,细节上有所缺失。相比之下,它的表现比SDXL更好一些,但在复杂提示词的执行上依然存在不足。

最后,我们看看我们自己的RPG模型。可以看到,RPG模型不仅生成了提示词中的所有元素——绿发女孩、橙色裙子、凌乱的桌子和水族箱——而且在细节处理上非常精准。水族箱的位置和桌子的凌乱感都非常符合提示词的要求,整个画面的布局也显得更加自然、真实。

这个案例展示了我们模型的强大之处:在复杂场景生成中,RPG模型的准确性更高,细节还原更加真实,并且能够完美捕捉提示词中的每一个元素。另外,通过二次编辑的功能,我们的模型还可以对生成的图像进行进一步的修改和优化,确保输出的质量更符合用户的期望。

总的来说,我们的RPG模型在生成复杂提示场景时不仅表现出了强大的图像理解能力,还可以通过进一步优化,确保生成图像的精度和细节更符合提示词要求。

接下来再展示我们的模型应用于AI生成图像在处理中文语境中的表现,特别是针对复杂提示词时的精准度对比。

首先,我们来分析提示词:‘一名中国将军头戴玉冠,蓄须,身穿金色的中国风格盔甲,胸前有一条壮丽的龙头,象征着他的力量,穿着黑色和金色的靴子,他的外表散发着权威,象征着勇敢和不屈的精神,体现了中国古代英雄的形象’。这是一个极其复杂的描述,需要模型准确理解中文的细腻表达,同时在图像中完美呈现人物的服饰、姿态和细节。

从对比结果来看,SDXL完全没有理解提示词中的描述,生成了错误的人物形象,甚至只生成了三节身体,缺乏完整性。这表明它在处理中文复杂提示时存在明显的障碍,无法捕捉提示词的核心信息。

DALL·E 3虽然生成了一个人物,但它未能表现出提示词中描述的细节,例如龙头盔甲和靴子等重要元素。整体形象不够精确,缺少中文提示词中的独特文化背景理解。

最后,我们看看RPG模型的表现。可以看到,RPG模型准确地还原了提示词中的所有细节。将军的头戴玉冠,盔甲上威风凛凛的龙头,黑色和金色的靴子等元素都完美展现,整个人物充满了力量感和权威感。这不仅展示了RPG模型对中文语义的深度理解,还能精准地捕捉中文语言中的复杂描述,并将其转化为图像。

除此之外,我们还展示了另一个提示词场景:‘桃园三结义’。同样的,RPG模型精准地生成了三位人物在桃花林中的场景,色彩和布局都非常符合中国文化语境的要求,而其他模型则未能正确生成。RPG模型在理解和处理中文提示词方面表现得更加出色,不仅能够精准生成符合文化背景的图像,还能深刻理解复杂提示词中的细微含义。

总结来说,RPG模型在应对复杂提示词和中文语境下的图像生成中,具有明显的优势。它不仅理解更准确,生成的图像也更加贴近提示词的原意,展示了我们模型在处理中文语言方面的强大能力。

AI+文生视频

我们还有文生视频的案例,具有生成效果细节丰富、更具中国风,能保持长视频多角度的一致性等优势。我们还推出了文生视频的案例,其生成效果细腻且富有细节,不仅展现了浓郁的中国风特色,还具备了在长视频中保持多角度一致性的优势,使视频内容更为协调、流畅。

AI+视听表现形式突破

我们还开发了3D数字人工具,实现了1:1的数字人克隆,只需一张照片即可生成,无需大型设备支持。此外,该工具支持3D写实实时互动,延迟低于200毫秒,可结合政企知识库,实时为用户提供互动服务。

与此同时,我们也在探索版权审核模型,通过自动化识别和比对影视数据的版权信息,降低人工审核工作量并提高审核效率。

从算法到艺术:国研能汇技术支撑

上述一系列的产品矩阵主要依赖于我们强大的技术支撑。国研能汇有坚实的技术基础支持,尤其是在AIGC复杂长视频生成解决方案上的技术优势和合作伙伴关系上。

国研能汇由北大PKU-DAIR实验室孵化,专注于AIGC视觉生成解决方案,并与微软、亚马逊、华为等国际知名企业合作,确保使用最先进的技术与基础设施。我们的战略伙伴包括央视网、广西广播电视台等媒体单位,帮助技术快速落地,广泛应用。

特别要感谢北大信息技术高等研究院的张国有教授、蒋云院长等一众专家,这些顶尖的专家为我们的研究提供了重要的技术指导和产业支持。这为我们的技术开发与创新提供了强有力的基础,也确保了我们在全球领先的AI领域始终走在前沿。

我们所提供的解决方案具有开放调用、低层模型自由切换的特点。这种架构在复杂的多交互场景中,能够实现极致的性能优化和表现优异的超长视频生成。而且,依托我们深厚的技术基础和高效的合作机制,我们的解决方案在成本控制方面也具备明显优势,这为客户和合作伙伴提供了极具竞争力的产品选择。

PKU-DAIR团队三年来在顶级AI会议发表数十篇论文,涵盖扩散模型的核心理论到应用落地,部分论文与OpenAI合作撰写,广受引用。2022年团队提出的ConPreDiff框架有效解决了复杂文本生成图像的难题,进一步提升生成的精确性和速度。2024年,团队还将发布SADM和RPG算法框架,大幅优化生成效果;ContextDiff框架则在图像与视频编辑中展现出优越性能。

这些成就展示了PKU-DAIR团队在扩散模型和智能生成内容领域的持续创新,团队的研究成果不仅推动了扩散模型的发展,还为文生图、文生视频、数字人等领域提供了坚实的技术支撑。PKU-DAIR团队近三年来在顶级AI会议上发布了数十篇论文,涵盖了从扩散模型的基础理论到复杂任务的落地应用。其中的一篇重要综述《Diffusion Models: A comprehensive survey of methods and applications》不仅是国内首篇对扩散模型进行全面阐述的文献,还与OpenAI合作撰写,已经被引用1000+次,表明了这项工作的广泛影响力。

在技术层面,2022年团队提出的ConPreDiff框架解决了复杂文本生图的问题,推动了扩散模型技术的应用,效果相对Stable Diffusion和OpenAI的DALL·E 2生成的精确性和速度得到了显著提升。

接着,在2024年的研究中,团队继续在顶级会议上发表更具创新性的工作。例如,在CVPR 2024提出的SADM,一种高效的扩散模型训练方法,显著提高了DiT模型的性能。在ICML 2024,团队将展示新型的RPG算法框架,通过复杂的prompt生成实现文生图效果的跨越性提升,达到SOTA(state-of-the-art)的水平。

此外,团队还提出了ContextDiff框架,这项研究在文生图和视频编辑领域展现出了卓越的性能,在2024年的ICLR会议上展示。可以看到,团队在研究方面有深厚的积累,推动了技术的快速应用。

这些成果反映了PKU-DAIR团队在扩散模型方向上的持续创新,他们在国内乃至全球的AI研究领域,都占据着非常重要的位置。团队的研究成果不仅推动了扩散模型的发展,还为文生图、文生视频、数字人等领域提供了坚实的技术支撑。

下面这张图展示了从底层技术到应用层的整个体系架构,涵盖了如何利用强大的AI模型和基础设施,推动智能生成内容在不同领域的实际应用。

我们构建了一个多模态AIGC平台,在应用层通过MaaS API提供文本、图像、音频和视频生成服务,为用户带来个性化解决方案。系统层通过MLLM Agent连接应用与基础模型,包括文本到图像的RPG生成模型和文本到视频的VisionConnect生成模型,实现精准内容生成。

基础模型层调用了GPT-4、SDXL、DALLE-3等开源与自研模型,涵盖智能问答、视觉生成、数据分析等多种功能。依托自研的Galvatron训练框架,系统能够快速训练和优化模型,确保生成内容的质量和速度。底层的数据层为模型提供多维度高质量数据(文本、图像、视频、3D),确保系统生成符合需求的内容。

这一完整技术架构支持智能问答、信息检索、文本与多媒体生成,适用于企业和个人创作,带来便利与创新。国研能汇的平台整合了最新AI技术,实现AIGC的高效应用与快速落地。首先,我们来看应用层和接口,这是整个系统的最上层。这里我们构建了一个多模态AIGC平台,可以通过MaaS(Model as a Service)API提供服务,确保更高质量的效果输出。这意味着我们不仅可以通过这个平台生成文本、图像、音频和视频,还能为用户提供高度个性化的解决方案,满足各种复杂的生成需求。

接下来是系统层,这是连接应用和底层模型的核心。我们通过MLLM Agent系统实现对用户需求的接收和规划。这包括了文本到图像的生成模型RPG,以及文本到视频的生成模型VisionConnect。这些系统确保了我们可以调用底层的多模态模型,为用户提供符合预期的内容生成。

进入Base Model(基础模型)层,我们可以看到系统调用了多种开源和自研模型。其中包括广为人知的GPT-4、LLaVa、SDXL、DALLE-3等开闭源模型,此外还有我们自研的视觉模型、音频模型和数字人模型。通过这种开闭源模型与自研模型的结合,系统能够处理各种复杂任务,比如智能问答、视觉生成、数字人、数据分析等。

在训练框架层,我们依托实验室自研的自动并行训练框架Galvatron,帮助我们快速训练和优化模型,确保生成内容的质量和速度。

最后,所有这一切的基础是数据层,我们拥有自研的LLM+Diffusion数据训练处理方案,涵盖了文本、图像、视频、3D等多维度数据。这为模型训练提供了大量的高质量数据,确保系统可以生成更加符合需求的内容。

通过这个全方位的技术架构,我们能够在产品输出端提供如智能问答、智能信息检索分析、文本、音频、图像和视频生成等多种解决方案。无论是在企业级应用还是个人创作中,这些生成能力都为用户带来了极大的便利和创新空间。

总结来说,国研能汇的平台不仅整合了最新的AI技术,还通过高效的算法和基础设施为各行业提供了强大的AIGC应用能力,从而实现了智能生成内容的快速落地。

未来已来:AI如何引领视听行业的数字化变革

沉浸式体验:未来视听新趋势

沉浸式体验正引领未来视听领域的新趋势,通过先进技术实现高度沉浸感将成为核心方向。未来的视听体验将不仅仅是观看,而是深度的情感沉浸。AI将带我们进入一个能触摸感官的数字世界。

首先,我们看到的感官模拟,这将是未来视听体验的核心。通过视觉和听觉的高度结合,打造出让用户仿佛置身于虚拟世界的体验。例如,在沉浸式太空体验中,AI生成的视觉和声音让用户仿佛身临其境。

高效运营和优化是未来趋势的亮点。数据驱动的决策支持使企业能够实时监控并优化内容表现,通过精确分析用户行为,AI自动调整内容呈现,以最低成本提供最佳体验,实现更精准的沉浸式效果。

此外,自动化交互技术为沉浸体验提供可靠支撑。智能内容调整系统利用AI生成3D音效和动态画面,与用户实时互动,带来更自然、连贯的沉浸式体验,增强用户参与感。

视听公众化:全民创造视听新内容

随着AIGC技术的逐渐发展成熟,首先,AI智能剪辑让长短视频界限逐渐模糊。其次,智能写作、文生图等工具,让创作者能够创作更快、更多、更优质的内容。最后,内容创作场景次元壁逐步被打破,AI生成的视觉效果应用越来越多,实景拍摄、真人上演的需求越来越少。

未来已来,让我们携手前行,共创未来,谢谢大家!

责任编辑:房家辉

24小时热文

流 • 视界

专栏文章更多

- 短剧榜单|3月美妆短剧竞逐女神节,电商品牌领跑短剧营销 2025-04-18

- [常话短说] 【破局】异业合作、跨界经营,广电自救新招式?! 2025-04-16

- 见微知著|对话张若波:多年芒果系转身微短剧得与失 2025-04-16

- [常话短说] 【解局】2025具体怎么干?多省广电给出答案! 2025-04-14

- [常话短说] 【重要信号】事关一体化电视,广电总局推进9地试点! 2025-04-10