本文导读:本篇文章是“基于开源大模型库快速实现AI应用”的系列教程之一。在上一篇《大语言变换器模型的架构及其工作原理介绍》中,我们全面地探讨了Transformer大模型的起源、基本结构、工作原理以及其在自然语言处理等领域的应用。文章还深入分析了自注意力机制的核心原理、计算过程,以及多头自注意力的具体实现。通过详细的案例,我们解读了三种Transformer模型:纯编码器模型、纯解码器模型,以及编码器-解码器结合模型,并对它们之间的差异及应用场景进行了阐述。

在本文中,我们将从一个端到端的实例出发,展示如何直接利用模型和分词器类函数,复现文章《利用开源Transformer模型实现主要的NLP文本相关应用》中所介绍的管道(pipeline)功能。此外,你还将了解如何使用模型的各种API进行配置,这包括加载模型和处理数值输入,从而得到预测结果。我们还将深入探讨分词器的各个处理步骤和功能,并在文章末尾展示如何使用大模型进行多句子的批处理,以及相关的注意事项。

关键词:Transformer(变换器)、分词器、架构、检查点、模型。

前文回顾:

AI技术干货|深度剖析transformer大模型管道功能背后的工作原理(上篇)

AI技术干货|深度剖析transformer大模型管道功能背后的工作原理(中篇)

5. Transformer编码过程

5.1. 编码

在自然语言处理领域,将文本转化为数字的操作称为编码。编码是让模型能够理解和处理文本的核心步骤,通常分为两个主要环节:首先是分词,接着是将分词后的结果转化为输入ID。

5.2. 分词

分词,也称为Tokenization,是自然语言处理中的一个关键预处理环节。它的主要任务是将输入的文本切分成更小的片段或单元,这些片段被称作token。模型往往不会直接处理完整的句子或段落,而是处理这些更细小的token,因此分词是编码过程中的首要步骤。

在分词的过程中,文本会被拆分成单词、符号或是单词的某个部分。以“Natural language processing is fascinating.”为例,分词后的结果可能是:['Natural', 'language', 'processing', 'is', 'fascinating', '.']。

分词的规则可能有所不同,这也是为什么在初始化分词器时,我们需要指定模型名称,确保我们使用的分词规则与模型在预训练时所采用的规则相符。

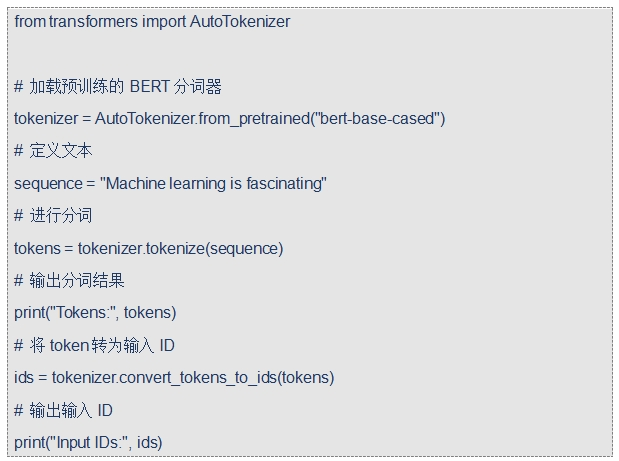

我们可以使用分词器的tokenize()方法来实现分词。下面是一个示例,展示如何利用AutoTokenizer从预训练的BERT模型中加载分词器,并对指定文本进行分词:

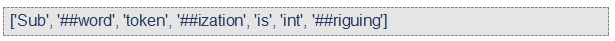

执行后,输出可能是:

从这个例子中,我们可以看到子词分词的特点。例如,“Subword”被拆分为“Sub”和“##word”,而“intriguing”被拆分为“int”和“##riguing”。这里的“##”表示该token是原词的一部分。

这种子词分词策略有助于处理生僻词和新词,因为即使整个词不在词汇表中,其子词可能存在,从而能够保留文本的语义信息。

5.3. 将token转为输入ID

完成分词后,我们需要将token转化为数字,即输入ID。因为计算机和机器学习模型主要通过数字和张量来处理信息,而不是直接处理文本。为了实现这一转换,分词器内部维护了一个词汇表。这个词汇表是我们通过from_pretrained()方法下载模型时的一个组成部分,它列出了所有可能的token及其对应的唯一数字ID。

以下是一个完整的示例,展示了如何将一个句子分词,并将分词结果转化为输入ID:

执行后,输出可能是:

在这里,每个token都被成功地转换为了一个唯一的数字ID(注意,这里的数字仅为示例,实际ID可能会有所不同)。这些数字ID接下来会被转换为适当的框架张量,然后可以作为模型的输入,完成各种自然语言处理任务。

5.4. 实践

为了更深入地理解这两个步骤,我们会在后续的内容中详细探讨,并展示一些中间结果。但在实际应用中,我们通常会直接调用分词器来完成整个编码过程,而不是分步骤执行,正如我们在前面的章节中所展示的。

通过这种方式,我们可以将原始文本有效地转化为模型可以理解和处理的格式,进而深入地理解和分析自然语言。

6. Transformer解码过程

VIP专享文章,请登录或扫描以下二维码查看

“码”上成为VIP会员

没有多余的门路、套路

只有简单的“值来值往”一路!

深度分析、政策解读、研究报告一应俱全

极致性价比,全年精彩内容不容错过!

更多福利,尽在VIP专享

24小时热文

流 • 视界

专栏文章更多

- [常话短说] 【解局】广电700M,迎高光时刻! 2025-03-25

- [常话短说] 【解局】广电上市公司财报分析! 2025-03-21

- [常话短说] 【解局】广电5G有个重要推动! 2025-03-19

- [常话短说] 【解局】某上市广电网又成立新公司,干啥?! 2025-03-14

- [常话短说] 【解局】广电有新举措!走出内容差异化之路! 2025-03-12